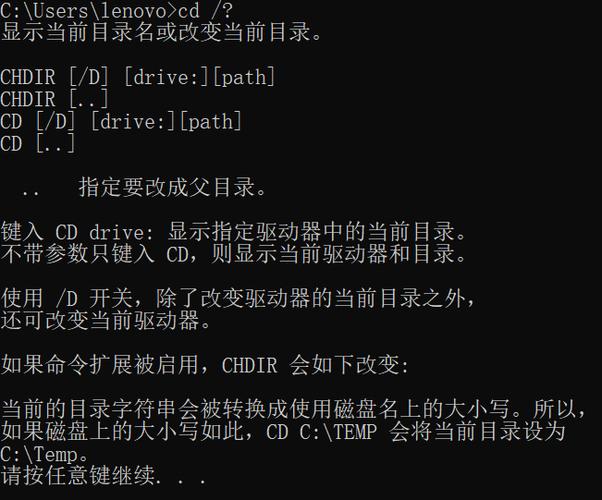

引言:大型语言模型(LLMs)已经成为研究和商业应用的热点,Ollama,作为一个创新的AI工具,现在推出了Windows预览版,为Windows用户提供了一个全新的本地化体验用户能够在原生的Windows环境中拉取、运行和创建大语言模型该版本支持英伟达的GPU,并需要CPU支持AVX和AVX2等指令集Ollama利用NVIDIA GPU和现代CPU指令集来加速模型运行,无需额外的配置或虚拟化目前该版本还在开发中,计划未来支持AMD GPU如果用户有能力,也可以直接从源码构建支持AMD GPU的版本Windows版的Ollama包括内置的GPU加速、访问完整的模型库,以及包括OpenAI兼容性在内的Ollama API本文将详细介绍Ollama on Windows Preview的运行使用项目地址:https://github.com/ollama/ollama?tab=readme-ov-file功能详情:1.硬件加速与兼容性:Ollama利用NVIDIA GPU和现代CPU指令集(如AVX和AVX2)来加速模型运行,无需额外配置或虚拟化这使得Ollama在Windows上的运行效率大大提高同时,Ollama的API设计允许与OpenAI的现有工具兼容,为用户提供了更多的灵活性2.完整的模型库:Ollama为用户提供了完整的模型库,包括视觉模型这意味着用户可以在Windows上运行如LLaVA 1.6等视觉模型,并通过拖放图片的方式将图像添加到消息中3.常驻API:Ollama的API在后台自动运行,服务地址为`http://localhost:11434`这使得工具和应用程序可以无需额外设置即可连接到API如何使用:1.下载安装Ollama:首先,下载Windows 上的 Ollamahttps://ollama.com/download/windows双击安装程序OllamaSetup.exe安装完成后,系统右下角要有“羊驼”logo,如果没有请运行它2.本地模型下载运行:然后,我们可以直接“Win+R”运行“cmd”命令行,或者启动“Windows PowerShell ”打开命令行终端工具随后,我们可以通过简单的命令行操作来运行本地模型我们运行名为`llama2`的模型,只需在终端中输入:“ollama run llama2” 终端会自动下载llama2模型并运行下次我们启动依然需要运行“ollama run llama2”加载模型下载完成后,我们就可以直接在命令行工具中进行对话了速度非常快,但我发现llama2对中文的支持并不友好对此我修改下载的模型为中文微调模型“ollama run llama2-chinese”下次我们启动依然需要运行“ollama run llama2-chinese”加载模型下面是支持的模型列表,和中文微调模型,大家可以自行选择下载官方提示注意:运行 7B 机型至少需要 8GB 内存,运行 13B 机型至少需要 16GB 内存,运行 33B 机型至少需要 32GB 内存3.PowerShell API调用:用户还可以通过PowerShell发送API请求,例如,使用以下命令来调用Ollama的API:

(Invoke-WebRequest -method POST -Body '{"model":"llama2", "prompt":"Why is the sky blue?", "stream": false}' -uri http://localhost:11434/api/generate ).Content | ConvertFrom-json这将发送一个包含模型名称、提示信息和流设置的JSON对象到Ollama的API,并接收响应总结:Ollama on Windows Preview的推出,为Windows用户带来了在本地运行大型语言模型的便利它的硬件加速功能、完整的模型库和常驻API为用户提供了强大的支持同时,与OpenAI的兼容性使得现有的工具和应用程序能够无缝集成尽管目前Ollama还在预览阶段,但它已经展现出了巨大的潜力和应用前景随着技术的不断进步和社区的积极参与,Ollama有望成为AI领域的一个重要工具我们期待看到更多开发者和研究者利用Ollama创造出令人兴奋的AI应用完over.关注我们,了解更多

0 评论